划重点:

1、赫拉利认为,AI带来的不仅是科学挑战,还是哲学挑战;当AI和生物科技结合,它将具备黑入人类大脑的能力。

2、李飞飞坚信:AI也正在解决一些以往没法解决的社会挑战和问题;并且决策不透明的挑战是有望被“可解释AI”解决的。

3、AI领域和其它人文领域需要有更多的对话和碰撞,建立机制,让AI科学家和社会学家、心理学家、哲学家一起工作。

《人类简史》、《未来简史》这两本书,不少人都听说过吧?

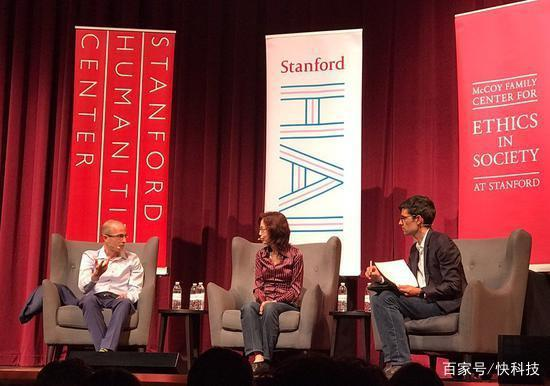

硅谷时间4月22日晚,在斯坦福可容纳约2000人的超级大演讲厅,以这两本畅销书享誉全球的以色列著名历史学家尤瓦尔赫拉利(Yuval Noah Harari),与斯坦福一个多月前神秘成立的“以人为本”AI研究院领导者李飞飞,展开了一场以人工智能为主题的对话。

对话现场有多火爆呢?

硅谷洞察的特约记者在开场前90分钟来到现场,发现演讲厅外面已排起了千米长队,还是两列队伍:一列提前订票的“坐票”,一列临时来听的“站票”。要知道,硅谷每天大小演讲无数,一场演讲能吸引200人来就算很不错了,如此火爆的演讲几乎史无前例...这气势,根本就是演讲届的《复联4》!

与赫拉利对AI的警惕与担忧不同,李飞飞对AI的发展可谓乐观不少。在这场讨论上,两位大咖针锋相对、各抒己见,都聊了些啥?硅谷洞察(原“硅谷密探”)这就带你去一探究竟!

(以下对话整理自现场,略有删减)

如果AI+生物科技入侵你的大脑,你还是你吗?

赫拉利用他在2018年出版的新书《21世纪的21堂课(21 lessons for the 21st century)》中提出的一个观点开场。

赫拉利:AI带来的不仅是一场科技挑战,还是一个哲学挑战。当AI和生物科技结合起来后,它就会具备‘黑掉’(hack)人类大脑的能力。这也就意味着,我们现在所谓的“自由意志”、“独立思考”、“民主决策”等,都将在机器的算法前分崩离析。几千年来,哲学家们讨论的诸多生存问题,会在工程师们调教出来的算法面前彻底变形。

具体点说,现在的人工智能建立在大量数据之上,一个AI算法已经能够比我们单个人脑做出更好的决策,比我们自己还了解自己。它准确知道我们喜欢什么、想买什么。它不仅能算出我们申请哪份工作更合适、怎样的投资理财最适合我们,甚至还能算出来跟谁约会更可能修成正果!

当算法可以做出比我更好的决定之际,再跟生物学研究结合起来,它当然就可以黑入我的大脑,在我不知不觉之际,悄无声息地背叛我,尤其是目前我们在数据隐私、安全和伦理上还存在这么多问题,这不是非常危险吗?

李飞飞:首先,人工智能的诞生就是从机器的算法与生物学,确切的说是脑神经学的对话和融合开始的。尤其是机器学习,它就是从模拟大脑的神经网络的。

其次,人工智能和生物医疗的融合目前在应用层面上已经产生了非常积极的作用,尤其是在医药和诊断等改善人们的医疗健康领域,两者深入融合将更多的造福人类。

此外,AI目前的发展带来的伦理、隐私和工作等多个社会问题已经被纳入了科学研究的视野和范围。斯坦福“以人为本”AI研究院应对这些挑战的一个解决方案是,重构我们下一代人工智能教育,尤其是我们将社会学家、心理学家、哲学家和AI科学家等多个领域的科学家们放到一起来研究,就是为了能更好的处理这些问题。

AI眼里的爱情,和一场流感又有什么区别?

“爱”这个永恒的话题,从石器时代被人类一直讨论到今天,AI时代也不例外。你害怕AI会黑入你的大脑,控制和操纵你的一切意志,那么,爱难道也可以被“黑”吗?

这就要从“爱”的定义谈起。

赫拉利:那要看你怎么定义“爱”。你觉得AI会爱吗?拥有意识吗?难道说,非人类的组织器官就无法识别和表达爱吗?

对AI来说,黑入爱、黑入意识的门槛可能是非常低的。如果你说的是爱情,从生物学的角度看,爱情的产生也不过是一连串的身体内的生物化学反应,荷尔蒙会变化,情绪和心跳会变化,使用的语言和动作会变化。如果机器的算法解码了爱情的这条生物化学反应链条,那么所谓的“爱情”跟一场流感有什么区别吗?

李飞飞:你这个结论里面有两个假设,第一,你假设我们现在的人工智能是如此之强大,强大到不可思议。它不仅能预测和判断我们的金融消费行为,还能预测到人类的爱和意识这个层次。这种AI离我们这个时代还很远、很远……我不知道我们还需要多少代人才能实现。

第二,你假设只有AI这种技术在未来一家独大,强大到凌驾于一切。事实上,过去,现在和未来,都有很多种其他科技和AI同时发展,有的技术甚至比AI还要强大。

所有的技术都有这样的双刃剑,落入坏人之手,就将危险人类社会和文明,这种例子在其他科技领域过去发生过,以后也可能会发生,AI也不例外,它可能误入坏人之手的负面影响不该被单独夸大。最重要的是,在应对AI的发展和可能的负面影响时,我们要把其他科技领域的玩家都一起带进来看,一起来面对和解决,因为它们也会在塑造我们的未来里扮演重要角色。

AI会把你“卖”给广告公司吗?

赫拉利:另一个很重要的问题是,现在的AI并不透明,我们常常在不经意间就给了AI大量关于我们自己的数据,而且我们也不知道它到底在对我们做什么。如果AI比我自己更了解自己,但它不跟我分享信息,而是跟广告商、大公司、政府组织联合来利用我,怎么办?

比如我现在去银行贷款,银行会通过一个非常复杂的、涉及几千个数据处理的软件系统,来决定能不能借给我钱、借给我多少钱。但是,这个过程根本没办法解释,它就是一堆代码和数据,它直接给我一个结论,请问现在有多少人是没办法弄懂银行这套系统,就直接按照它的结论来操作的?

李飞飞:这正是为什么我们斯坦福“以人为本”AI研究院设定了几个核心的研究原则。其中一个很重要的原则,就是我们会更注重能够更好解释或反应人类智能的AI技术的发展,比如“可解释AI(explainableAI)”以及对数据库的依赖更少的机器学习方法,比如直接从人类的经验、创造性和学习方式得到启发,更接近人类的人工智能技术。

“可解释AI”的软件在生物医学和法律、金融等多个领域应用的潜能如此之大。你提到的数据不透明,决策不透明的过程将是有望被AI来解释清楚的。反过来说,如果AI可以更好的解释和呈现一个决策过程,那很多我们以往没办法量化的事情以后就无法来弄虚作假了。

另一个原则,是我们会和跨学科的科学家们以及政策制定者,企业家们一起工作,更好定义和应对AI会引发的隐私、伦理乃至政治和经济问题。目前,我们已经有超过200多位斯坦福的学者参与其中了。

而且,AI本身也可以用于正面的解决一些以往没法解决的社会挑战和问题。比如,机器学习可以通过算法来“反偏见”,它可以分析电影中男性的数量和呈现时间,与女性做对比,来证明到底有没有性别偏见。这种级别的分析是人类无法做到的。

赫拉利:我觉得一个解决方法是,我们每个人要更好的更多的了解自己,不要让AI比我们更了解自己。只要AI不如我们自己了解自己,AI替我们做主的威胁就会小很多...不过话说回来,我们很多人真的一点也不了解自己。

AI全球竞赛,或比核竞赛更可怕

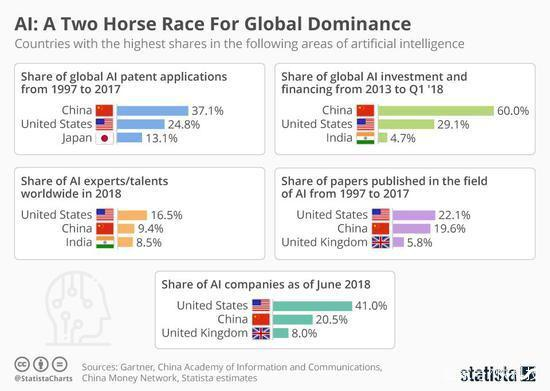

赫拉利:另一个让我担心的是,AI发展是一个少数国家,尤其是中、美两国占主导优势的技术领域。很多其他非洲国家、亚洲国家,乃至欧洲国家在这个领域已经远远落后于亚马逊或者腾讯。

而且更可怕的是,在AI的发展中,竞争的感觉越来越浓,而不是合作。如果AI演变成一场全球科技竞争,那是对全人类的一个坏消息。

从经济上讲,这种AI发展不平衡、一两家独大的局势,将很可能以数据殖民的方式重现19世界的全球殖民地统治。

比如,19世纪时的印度是英国的殖民地,它的经济是围绕殖民地的需求来设计的,只不过它当时供应给英国的是茶园和鸦片,现在它可能供应给加州的是它的大量数据和基础的数据处理服务,然后这些东西流到加州后,进入那些创业公司,变现为走向全世界的一个算法或服务。

从政治上讲,那些AI发展落后的国家会在这种竞争里变得更紧张,因为,即便我已经出局了,我也不希望任何一家做大啊!如果有一天美国的人工智能世界第一,只要它是只服务于美国的利益的,我怎么能够信任它提供的服务呢?而且,一旦有天加州的AI技术和算法能取代那些现在靠便宜产品生存的国家,那些国家的经济甚至会引发崩溃。

所以我说,AI的全球竞赛,将比核竞赛更可怕。因为,虽然核武器大家都在竞赛,但至少只是研发出来作为底气壮胆,没有人会随便去用的。但是AI就不一样了,它是发展出来就马上会被用,不管三七二十一。

李飞飞:如今的科学在全球范围内的合作和交流非常频繁,超出你想象,AI领域更是一个跨国界的合作研究和应用社区,仅在斯坦福,每年的全球合作产生的科学论文数量就多不胜举,还有GitHub这种全球的开源服务社区。

所以,你所说的这种情况,在全球交流和合作如此频繁的当下,不太会发生。确实很多AI现在资源是在少数大公司里,但不是全部,其实学术界和很多独立研究机构在AI发展里都有自己的独立角色。

而且,那些目前在这个领域落后的国家,还是有很多机会和时间去思考、制定自己的数据战略和AI发展战略的。

结语

今天的AI科学家们要处理的实在太多了,除了技术领域研究,还要回答道德、伦理、隐私、经济、政治,乃至爱情等方方面面的问题。就像李飞飞在对话中开的一个玩笑,“科学家们真的很忙,我羡慕哲学家们,他们可以只提出问题来,用几千年来反复讨论却没有个答案,而我们科学家们却要马上回答。”

这让记者想到几天前采访一个生物科学家时,他提到的观点:“我们科学家受的解决研究问题的学术训练,你提到的基因编辑引发的这些伦理和社会问题,我怎么知道答案呢,你应该去问那些领域的专家,或者干脆去问你们每个人自己:这真的是我想要的吗?”